质量重于数量:平衡大型语言模型的算法透明度、问责制和知识产权

在我们对推动算法革命的数据展开研究的过程中,算法透明度和问责制是核心原则。一些人可能误认为这种说法是在隐晦地呼吁公开知识产权。然而,经过细致入微的研究,我们发现了一个更加复杂的叙事,即大型语言模型和专有模型之间的区别。

大型语言模型是在综合文本数据集上训练而成的AI系统,其设计意图是根据输入内容生成类似人类的文本。“大型”一词体现了模型在参数数量和训练数据量上的规模。比如OpenAI 的GPT-3在训练时运用了一个包含1750亿个海量文本参数的巨大模型。这些模型必须能够理解它们生成的文本,通过辨别训练数据中的模式来生成并输出预测结果。一个不变的原则是:只有综合全面的高质量训练数据才能使模型生成准确的预测结果。

与之相反的是,“专有模型”通常由特定实体或公司创建。其设计、结构和算法保护创建者的知识产权。这个词往往指的是蓝图可供公众使用、修改和传播的开源模型。值得注意的是,专有模型与大型语言模型没有本质区别,使用“专有模型”这个术语是为了强调模型的其他特征。

以OpenAI的GPT-3为例,它既可以是大型语言模型,也可以是专有模型。网络安全行业给出了一个恰当的比喻:“垃圾进,垃圾出”。与网络卫生实践一样,为模型提供经过整理的高质量数据可以影响输出结果,在实现精准异常检测的同时推动创新。

那么如何防止数据中毒呢?关键在于用细致入微的数据采集和整理取代杂乱无章的数据积累。无论是专有模型还是开源模型,确保采集高质量的数据可以帮助提升模型输出结果的准确性。决定模型有效性的最终因素是数据的质量和相关性,而非数据的数量。

算法透明度要求明确算法的一般操作。例如贷款决策算法应说明其考虑的因素(收入、信用评分)及各项因素的权重。与之相对应的算法问责制则要求实体对其算法决策负责,尤其是当出现迹象表明结果带有偏差或差别时。

由于应用了机器学习,入侵检测系统(IDS)可监视网络是否存在潜在威胁或违反政策的情况。机器学习可以根据以往数据识别威胁,大大提升了IDS 的能力。但即便如此,透明度和问责制方面仍然存在挑战。

因此,算法透明度的“潜台词”是IDS 用户需要对决策依据具备一定的了解。例如,威胁信号的特征是什么?IDS如何区分正常活动和恶意活动?虽然为了避免给攻击者提供“参考”而不能公布具体的系统机制,但用户只有在掌握足够信息的情况下才能信任并有效利用该系统。

算法问责制提出了误报和漏报的责任问题。IDS 提供商应对此类错误承担责任,尤其是当这些错误是由算法缺陷引起时。

目前挑战在于如何在透明度、问责制、专有利益保护和潜在攻击防范之间保持平衡。这是一项涉及多方面的任务,需要细致入微的考量和各方面兼顾的方法。另外,需要认识到理解某些算法(如神经网络)的决策过程及保护专有信息的技术复杂性。然而尽管存在这些障碍,但对于优化算法透明度和问责制,专家们已经达成共识。

鉴于日益智能和先进的黑客技术所带来的威胁迫在眉睫,网络安全行业必须拥有同等资源才能对抗这些AI驱动的攻击。从长远来看,安全行业的目标不仅是让一群人类威胁猎手通过猜测来零散地解决问题。

当务之急是采取智能化措施来化解这些不断发展的威胁。作为全球网络安全领导企业,Palo Alto Networks(派拓网络)一直在加速AI在网络安全堆栈中的应用,是当今安全行业最成熟的AI应用之一。派拓网络不仅在人工智能和机器学习方面的投资处于领先地位,而且还致力于将这些投资转化为客户可以获得的实实在在的利益。

提交

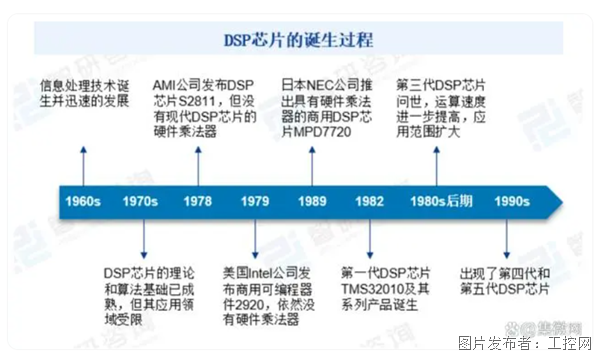

DSP应用市场的大蛋糕,国产厂商能吃下多少?

智能工控+存储-星火存储打造智慧存储,助力产业创新

智能工控+存储-金胜电子焕新品牌助力国产工控市场

应对人工智能数据中心的电力挑战

Saab UK 为深海勘探实现创新,降低潜水员及环境风险

投诉建议

投诉建议